Guides & Best Practices

Alle Posts ansehen5 häufige A/B-Test-Fehler (und was du stattdessen tun solltest)

A/B-Testing ist ein Game-Changer für die Optimierung deines Funnels und zur Steigerung der Conversions – doch es läuft nicht immer reibungslos ab. Richtig gemacht, kann es unschätzbare Insights liefern, die das Wachstum deines Unternehmens vorantreiben. Schlecht gemacht, kann es zu falschen Schlussfolgerungen führen und Zeit und Ressourcen für unnötige Änderungen verschwenden.

Fakt ist, dass viele A/B-Tests wegen vermeidbarer Fehler nicht die Ergebnisse liefern, die sie sollten. Dieser Artikel wird diese Fallstricke untersuchen und praktische Lösungen anbieten, um sie zu umgehen und um sicherzustellen, dass deine Tests klare Erkenntnisse liefern, die umgesetzt werden können. Mit den richtigen Tools – wie Heyflows leistungsstarken Analyse- und Test-Features – kannst du deinen A/B-Testing-Prozess für deinen Funnel optimieren und smarte Entscheidungen für bessere Ergebnisse treffen.

Fehler 1: Keine praxisbezogenen Insights aus früheren Tests nutzen

Viele Teams stürzen sich in neue Tests, ohne vorherige Testergebnisse zu prüfen, was zu unnötigen oder unvollständigen Experimenten führt. Wenn du nicht genau weißt, was in der Vergangenheit funktioniert hat und was nicht, riskierst du, Fehler zu wiederholen oder Optimierungsmöglichkeiten zu verpassen. Jeder Test, den du durchführst, ist eine Chance, mehr über deine Zielgruppe zu lernen und deine Strategie zu verfeinern – verschwende sie also nicht durch mangelnde Vorbereitung.

Aus diesem Grund solltest du vergangene A/B-Testergebnisse prüfen, die für dein Unternehmen momentan relevant sind – und die Erkenntnisse daraus zur Ausrichtung deiner aktuellen Strategie nutzen. Indem du dir Daten aus der Vergangenheit nochmal anschaust, baust du auf etwas auf, das bereits getestet wurde. Anstatt bei Null zu beginnen, basieren deine Optimierungen auf früheren Ergebnissen. Auf diesem Weg verstehst du, was für ähnliche Funnels, Landingpages oder Zielgruppen funktioniert hat – und kannst basierend auf diesen Learnings ein kontinuierliches System erstellen, um Experimente mit einer höheren Erfolgswahrscheinlichkeit zu gestalten.

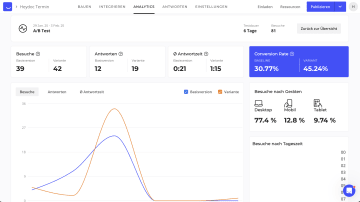

Heyflow macht das einfach, da es im Analytics-Dashboard direkten Zugriff auf historische A/B-Testergebnisse bietet – einschließlich wichtiger Metriken wie Besucher:innen nach Gerät oder Conversion-Rate für jede Variante. Dieser Kontext ist entscheidend, um deine Teststrategie zu verbessern und Fehler nicht unnötig zu wiederholen.

Fehler 2: Zu viele Elemente auf einmal testen

Bei der Erstellung eines Leadfunnels, Formulars oder einer Landingpage kann es verlockend sein, zwei völlig unterschiedliche Varianten zu erstellen, die nichts gemeinsam haben, um so viele Änderungen wie möglich zu testen. Das führt aber oft zu Verwirrung und verfälschten Ergebnissen. Denn wenn zu viele Variablen im Spiel sind, ist es schwierig festzustellen, was genau die Änderung der Performance verursacht hat. So ist es fast unmöglich, klare Insights aus dem Test zu gewinnen.

Statt deinen Test mit zu vielen Variablen zu überladen, konzentrier dich besser auf eine oder nur wenige spezifische Änderungen gleichzeitig. So bekommst du klarere Insights und erkennst, was wirklich besser funktioniert. Im Ergebnis bekommst du praxistaugliche Daten, um deine nächsten Schritte zu planen.

Wenn du dir nicht sicher bist, was du testen kannst und Ideen brauchst, schau dir unseren Blogartikel an: 7 Dinge, die du in deinem Heyflow mit unserer neuen A/B-Testfunktion testen kannst.

Fehler 3: Keine präzisen und hochwertigen Daten pflegen

Datenqualität ist die Grundlage jedes erfolgreichen A/B-Tests. Kompromittierte Daten – sei es durch Fehler im Setup oder Probleme während der Testphase – können Ergebnisse verzerren und zu falschen Entscheidungen führen. Zum Beispiel kann ein plötzlicher Einbruch des Traffics – verursacht durch technische Störungen oder durch Probleme bei Werbekampagnen – Daten verzerrt wiedergeben. So wird es schwierig, die tatsächliche Auswirkung deiner Änderungen richtig einzuschätzen.

Um das zu vermeiden, solltest du deine Daten bereinigen und validieren. Mit Heyflow wird dieser Prozess einfacher, da du deine Testdaten zurückzusetzen und bei Bedarf neu starten kannst. Klicke einfach auf den „Clear Analytics"-Button und dein A/B-Test beginnt mit einem sauberen Slate von vorn. So stellst du sicher, dass du für deine Entscheidungen relevante und zuverlässige Daten hast.

Abgesehen von der Bereinigung ist auch eine tiefgehende Analyse der Qualität deiner gesammelten Daten wichtig. Heyflow reichert die Daten der Antworten mit Varianteninformationen an, die an CRMs und andere integrierte Tools gesendet werden können. So kannst du analysieren, welche Variante nicht nur besser konvertiert, sondern auch die qualitativ hochwertigeren Leads bringt. Zum Beispiel könnte Version A mehr Conversions generieren, während Version B die wertvolleren Antworten liefert. Dieses Wissen ist entscheidend, um informierte Entscheidungen über die reinen Zahlen hinaus zu treffen.

Fehler 4: Den Traffic zwischen den Varianten nicht richtig verteilen

Viele User bleiben bei A/B-Tests bei der Standard-50/50-Aufteilung des Traffics zwischen beiden Varianten. Das kann zwar ein guter Anfang sein, ist aber nicht immer die beste Strategie – besonders bei Tests mit größeren oder radikaleren Änderungen. Eine gleichmäßige Verteilung des Traffics ist vielleicht nicht die beste Wahl, wenn du riskante Variationen testest, eine schrittweise Einführung planst oder wenn du das Risiko minimieren willst, falls eine Variante schlecht performt.

Wenn du die Verteilung des Traffics anpasst, kannst du die Sichtbarkeit kontrollieren und sicherstellen, dass deine Testergebnisse zuverlässig und aussagekräftig sind. Testest du zum Beispiel ein großes Redesign, möchtest du vielleicht für die neue Variante mit einem kleineren Anteil an Traffic starten, um das Risiko zu minimieren.

Mit Heyflow kanns du den Traffic-Anteil für jede Variante ganz einfach anpassen. So hast du mehr Kontrolle darüber, wie dein Test abläuft. Egal ob du Änderungen schrittweise einführen oder eine radikalere Idee testen willst – du kannst die Traffic-Verteilung genau auf die Bedürfnisse deines Tests abstimmen.

Fehler 5: Zu früh Tests beenden, bevor statistische Signifikanz erreicht ist

Vorschnelle Schlüsse ohne tieferes Verständnis deiner Testergebnisse können zu falschen Entscheidungen führen. Ein klassischer Fehler ist, bei der Auswertung statistische Signifikanz und Wahrscheinlichkeiten zu ignorieren. Wenn du die Erfolgschancen nicht richtig einschätzt, könntest du uneindeutige Ergebnisse als Fakten betrachtet – oder verlässt dich bei Entscheidungen auf Daten, die vordergründig einen Erfolg signalisieren, sich aber hinterher als falsch erweisen.

Um das zu vermeiden, beziehe in deine Interpretationen immer die statistische Wahrscheinlichkeit eines Erfolgs ein. So merkst du, ob eine Variante wirklich besser performt oder ob die Ergebnisse einfach zufällig sind. Mit Metriken der Wahrscheinlichkeit triffst du sichere Entscheidungen und minimierst das Risiko, auf unzuverlässige Daten zu setzen.

Heyflow liefert dir Wahrscheinlichkeits-Indikatoren für A/B-Test-Gewinner. So siehst du auf einen Blick, ob Ergebnisse statistisch signifikant sind. Mit klaren Signalen, ob das Testergebnis eindeutig oder noch unsicher ist, triffst du klügere und sichere Entscheidungen – alles datenbasiert.

Fazit

A/B-Testing ist ein wichtiges Werkzeug – doch dabei solltest du häufige Fallstricke vermeiden, die zu ungenauen Ergebnissen führen können. Indem du aus vergangenen Tests lernst, dich auf Schlüsselelemente konzentrierst, präzise Daten pflegst, den Traffic richtig verteilst und Ergebnisse mit statistischer Signifikanz interpretierst, kannst du deine Teststrategie optimieren und deine Conversion-Rates boosten.

Mit Heyflows verbesserten A/B-Testing-Features bist du darauf vorbereitet, diese Fehler zu vermeiden – und kannst Tests durchführen, die zuverlässige Erkenntnisse liefern, die du in der Praxis nutzen kannst.

Starte noch heute deine kostenlose Testphase und bring dein A/B-Testing auf das nächste Level!